Pochi giorni fa è stata presentata dalla Commissione Europea la bozza del “Regolamento sull’approccio europeo per l’intelligenza artificiale”.

Il Regolamento, sui temi dell’intelligenza artificiale, ha come obiettivo stabilire norme armonizzate e trovare un punto di equilibrio tra la complessità l’enorme potenziale della tecnologia e la tutela dei cittadini.

L’avanzamento tecnologico ha portato negli ultimi anni questi sistemi ad evolversi molto rapidamente e a costituire un grande beneficio sia dal punto di vista economico che sociale.

L’uso dell’intelligenza artificiale porta numerosi vantaggi, ottimizzando per esempio le operazioni, l’allocazione delle risorse e la personalizzazione nei più svariati settori: agricolo, sanitario, educativo, nei trasporti, nella logistica, nella sicurezza, nella gestione delle infrastrutture, fino al contenimento dei disastri provocati dal cambiamento climatico.

Ma c’è anche il rovescio della medaglia.

Alcune improprie applicazioni dell’intelligenza artificiale potrebbero causare danni anche molto gravi, violando alcuni principi fondamentali individuali tutelati dal diritto dell’UE.

È necessario, dunque, in questo specifico storico, sviluppare un “quadro normativo che istituisce un approccio europeo per promuovere lo sviluppo e l’adozione di sistemi di intelligenza artificiale che, al tempo stesso, soddisfino un elevato livello di protezione degli interventi pubblici”.

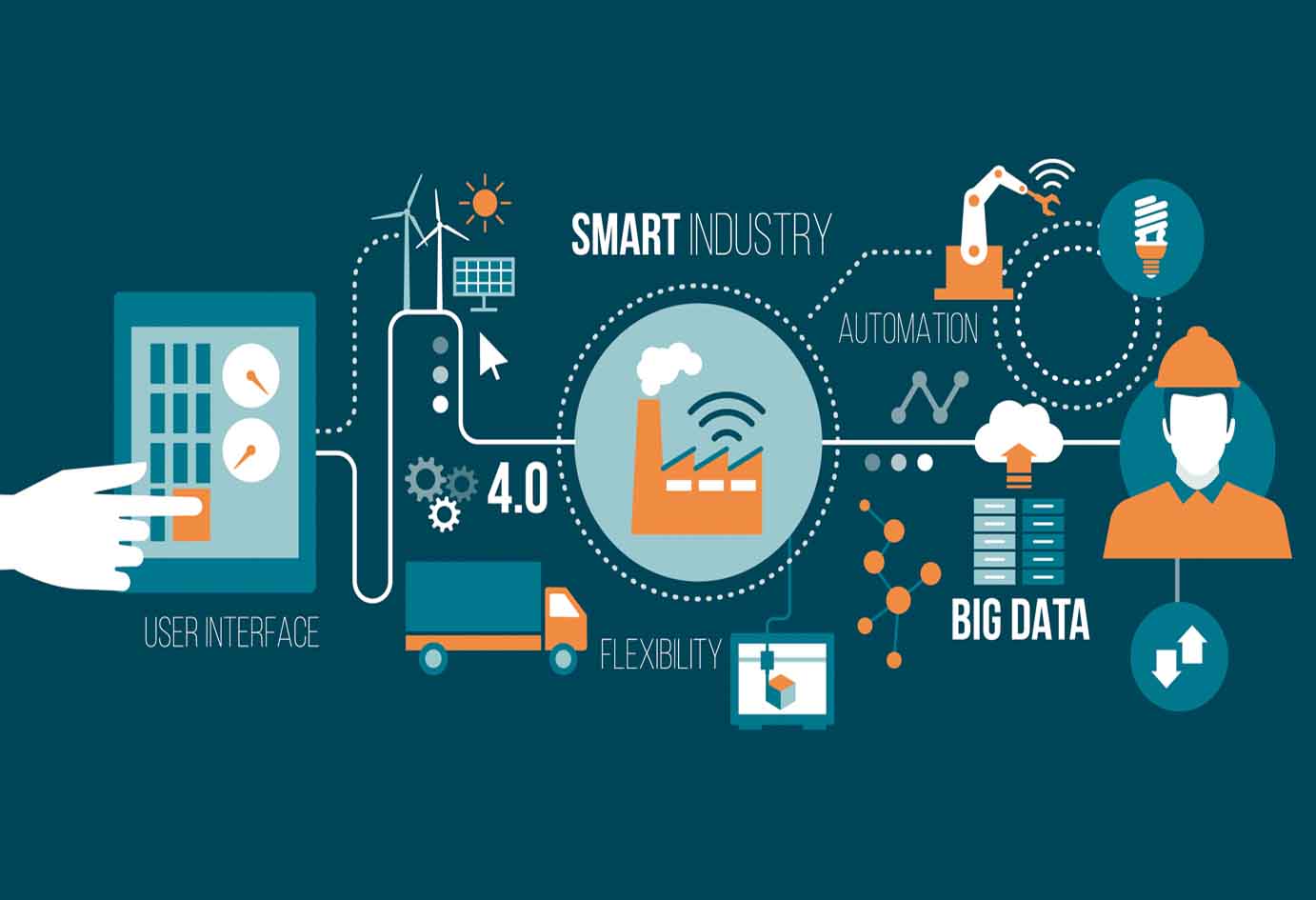

Tre le iniziative legali interconnesse proposte dalla Commissione per rendere l’Europa un “ecosistema” sicuro e favorevole allo sviluppo dell’Intelligenza artificiale:

- Quadro giuridico europeo per l’AI per affrontare i diritti fondamentali e i rischi di sicurezza specifici dei sistemi AI

- Norme UE per affrontare la questione delle responsabilità legate alle nuove tecnologie, inclusi i sistemi AI

- Revisione della legislazione sulla sicurezza

Tra le pratiche vietate in materia di intelligenza artificiale troviamo la messa in servizio o l’uso di intelligenza artificiale che utilizza tecniche di persuasione che potrebbero causare danno fisico o psicologico alla persona o a terzi, che sfrutta la vulnerabilità delle persone al fine di falsare il comportamento e creare danno a sé o ad altri, e che fa la valutazione e la classificazione dell’affidabilità delle persone fisiche sulla base del loro comportamento sociale.

L’uso del riconoscimento facciale e di identificazione biometrica remota in tempo reale è previsto ai soli fini della sicurezza pubblica e come prevenzione della criminalità, previa concessione da parte di un’autorità giudiziaria o amministrativa competente.

Specifichiamo che sulla base della definizione di “dato biometrico” da GDPR, il Regolamento definisce “sistema di identificazione biometrica da remoto”, un sistema automatizzato il cui scopo è quello di identificare le persone a distanza sulla base dei dati relativi alle caratteristiche fisiche, fisiologiche o comportamentali di una persona fisica che ne consentono o confermano l’identificazione univoca, quali immagine facciale o dati dattiloscopici”.

In linea con quanto previsto dal GDPR, il produttore ha l’obbligo di svolgere un c.d. conformity assessment, ossia prima della commercializzazione deve dimostrare che siano rispettati i principi del Regolamento facendo la valutazione del rischio.

Il Regolamento sull’AI prevede l’implementazione di un sistema di gestione del rischio, espresso in maniera documentale e periodicamente monitorato e ottimizzato in relazione al mutamento del rischio connesso all’utilizzo dei sistemi di intelligenza artificiale.

I set di dati utilizzati nella fase di sviluppo e testing del sistema dovranno essere dotati di proprietà statistiche appropriate in relazione alla categoria di persone sulle quali è destinato l’utilizzo del sistema di AI.

È previsto inoltre l’obbligo di trasparenza sul funzionamento del sistema da parte del fornitore della tecnologia, che deve fornire tutta la documentazione tecnica che dimostri la compliance ai requisiti del regolamento e istruzioni d’uso concise, complete, chiare, accessibili e facilmente comprensibili.

Infine, deve essere garantita l’affidabilità e la sicurezza del sistema da parte del responsabile del trattamento, che ha l’obbligo di attuare tutte le misure tecniche e organizzative adeguate al rischio, tenendo conto anche dei rischi legati alla distruzione, perdita, modifica o divulgazione accidentale dei dati trattati.

Autorità nazionali competenti e l’European Data Protection Supervisor dovranno istituire degli ambienti di controllo, denominate “regulatory sandbox”, su modello del Regno Unito, per il collaudo e il controllo dei sistemi AI prima dell’immissione sul mercato.

Per agevolare PMI e start up che vogliano sfruttare le opportunità legate allo sviluppo dei sistemi AI, il Regolamento ha previsto delle misure come l’accesso prioritario ai “regulatory sandbox”, le attività formazione per l’applicazione del Regolamento e l’istituzione di un canale di comunicazione tra fornitori e utenti su piccola scala.

Ulteriori approfondimenti sul sito dell’Unione Europea

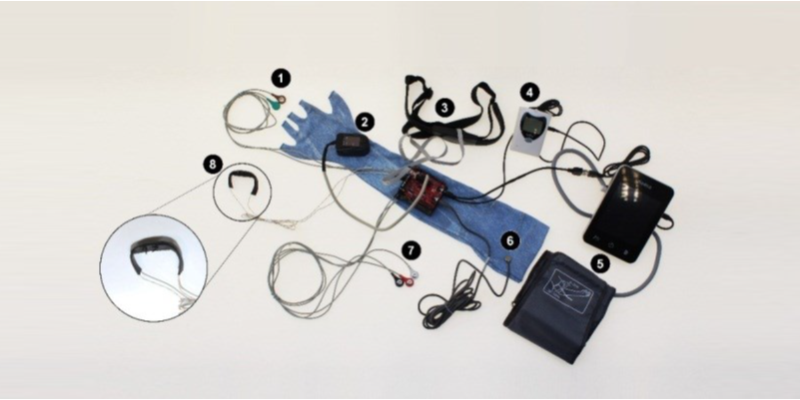

Dyrecta Lab in qualità di Istituto di Ricerca e Centro di Trasferimento tecnologico ha sviluppato diversi progetti di ricerca nell’ambito di sistemi intelligenti con approccio umano-centrico e nel pieno rispetto della tutela della privacy, secondo le normative vigenti.